Imagínese una persona que lee estas palabras en una computadora portátil en un café. La máquina de metal, plástico y silicio consume unos 50 vatios de potencia, ya que traduce bits de información —una larga cadena de 1s y 0s— en un patrón de puntos en una pantalla. Mientras tanto, en el interior del cráneo de la persona, una viscosa agrupación de proteínas, sal y agua utiliza una fracción de esa energía no sólo para reconocer esos patrones como letras, palabras y oraciones, sino para reconocer la canción que suena en la radio

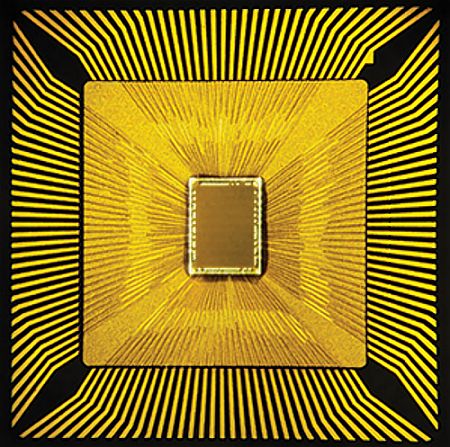

Este chip de computadora, realizado por IBM en 2011, cuenta con

componentes que rinden como 256 neuronas y 1024 sinapsis

Las computadoras son muy ineficientes en un montón de tareas que son fáciles incluso para los cerebros más simples, tales como el reconocimiento de imágenes y moverse por espacios desconocidos. Las máquinas que se encuentran en los laboratorios de investigación o en los grandes centros de datos pueden realizar estas tareas, pero son enormes y consumen mucha energía, y necesitan programación especializada. Google fue noticia recientemente con un software que puede reconocer de forma fiable los rostros humanos y de los gatos en los clips de vídeo, pero este logro requiere no menos de 16.000 procesadores potentes.

Una nueva generación de chips de computadoras que operan más parecido al cerebro puede estar a punto de cerrar la brecha entre la computación artificial y natural, entre los circuitos que operan mediante operaciones lógicas a velocidad de vértigo y un mecanismo perfeccionado por la evolución para procesar y actuar sobre la información sensorial del mundo real. Los avances en la neurociencia y la tecnología de chips han hecho que sea práctico construir dispositivos que, a pequeña escala, por lo menos, procesen los datos de la manera en que lo hace el cerebro de los mamíferos. Estos chips «neuromórficos» pueden ser la pieza que falta en muchos proyectos prometedores pero inacabados de inteligencia artificial, como los coches que se conducen solos que sean fiables en todas las condiciones, y los teléfonos inteligentes que actúen como auxiliares de conversación competentes.

«Las computadoras modernas son heredadas de las calculadoras, buenas para trabajar con números», dice Dharmendra Modha, investigador de IBM Research en Almaden, California. «Los cerebros evolucionaron en el mundo real». Modha conduce uno de los dos grupos que se han construido chips de computadora con una arquitectura básica copiada del cerebro de los mamíferos en un proyecto de us$ 100.000.000 llamado Synapse (sinapsis), financiado por la DARPA (agencia de proyectos avanzados de investigación) del Pentágono.

Los prototipos ya han demostrado chispas iniciales de inteligencia, procesando imágenes de manera muy eficiente y obteniendo nuevas habilidades en una forma que se asemeja al aprendizaje biológico. IBM ha creado herramientas para permitir que los ingenieros de software programen estos chips inspirados en el cerebro. El otro prototipo, en HRL Laboratories en Malibu, California, pronto será instalado dentro de un pequeño avión robótico, el que aprenderá a reconocer su entorno.

La evolución de los chips inspirados en el cerebro comenzó a principios de 1980 con Carver Mead, profesor en el Instituto de Tecnología de California y uno de los padres de la informática moderna. Mead se había hecho un nombre por ayudar a desarrollar una forma de diseño de chips de computadora llamado integración a escala muy grande, o VLSI, lo que permitió que los fabricantes pudiesen crear microprocesadores mucho más complejos. Esto dio lugar a un crecimiento explosivo en potencia de cálculo: se vio a las computadoras llegar a la vida común, incluso ser embebidas en todas partes. Pero la industria parecía feliz de construirlas en base a un diseño que data de 1945. La arquitectura de von Neumann, llamada así por el matemático de origen húngaro John von Neumann, está diseñada para ejecutar secuencias lineales de instrucciones. Todas las computadoras de hoy en día, desde los teléfonos inteligentes a los superordenadores, tienen sólo dos componentes principales: una unidad central de procesamiento, o CPU, para manipular los datos, y un bloque de memoria de acceso aleatorio, o RAM, para almacenar los datos y las instrucciones sobre cómo manipularlo. La CPU comienza por ir a buscar su primera instrucción en la memoria, seguida de los datos necesarios para ejecutarla; después se lleva a cabo la instrucción, el resultado se envía de nuevo a la memoria y se repite el ciclo. Incluso los chips de varios núcleos que manejan datos en paralelo se limitan a unos pocos procesos lineales simultáneos.

Este enfoque se desarrolló naturalmente de las matemáticas y la lógica teórica, donde los problemas se resuelven con cadenas lineales de razonamiento. Sin embargo, era inadecuado para el procesamiento y el aprendizaje a partir de grandes cantidades de datos, en especial la información sensorial, como las imágenes o el sonido. También tiene limitaciones en su funcionamiento: para hacer las computadoras más potentes, la industria se puso a construir chips cada vez más complejos, capaces de llevar a cabo operaciones secuenciales más y más rápido, pero esto puso a los ingenieros a ocuparse de lograr mayor eficiencia y a usar refrigeración, debido al problema de que los chips más rápidos producen más calor residual. Mead, ahora de 79 años, y un profesor emérito, sintió incluso entonces que no se podía hacer de una mejor manera. «Cuanto más pensaba en ello, más torpe me sentía», dice, sentado en la oficina que mantiene en Caltech. Comenzó a soñar con chips que procesaran muchas instrucciones, quizás millones, en paralelo. Un chip así podría realizar nuevas tareas, manejo eficiente de grandes cantidades de información no estructurada, como el vídeo o el sonido. Podría ser más compacto y ser más eficiente en el uso de energía, aqunue fuese más especializado para determinados tipos de tareas. La evidencia de que esto era posible podía encontrarse volando, corriendo y caminando por todas partes. «Los únicos ejemplos que veíamos de cosas paralelas masivas estaban en los cerebros de los animales», dice Mead.

Los cerebros calculan en paralelo cuando las células eléctricamente activas dentro de ellas, llamadas neuronas, operan de manera simultánea y sin cesar. Embebidas en redes intrincadas de apéndices filiformes, las neuronas se influyen entre sí con impulsos eléctricos a través de conexiones llamadas sinapsis. Cuando la información fluye a través de un cerebro, éste procesa los datos en una descarga de picos que se extienden a través de sus neuronas y sinapsis. Reconoces las palabras en este párrafo, por ejemplo, gracias a un patrón particular de actividad eléctrica en el cerebro provocado por lo que entra por tus ojos. Fundamentalmente, el circuito neural también es flexible: una nueva entrada puede causar que las sinapsis se ajusten a fin de darle algunas neuronas más o menos influencia sobre las demás, el proceso en el que se basa el aprendizaje. En términos de computación, es un sistema masivamente paralelo que puede reprogramarse.

Irónicamente, a pesar de que ha inspirado los diseños convencionales que perduran hoy en día, von Neumann había percibido también el potencial de la computación inspirada en el cerebro. En su libro inconcluso The Computer and the Brain (La computadora y el cerebro), publicado un año después de su muerte en 1957, se maravillaba del tamaño, la eficiencia y el poder del cerebro en comparación con las computadoras. «Un estudio matemático más profundo del sistema nervioso … puede alterar la manera en que vemos las matemáticas y la lógica», argumentaba. Cuando Mead llegó a la misma conclusión más de dos décadas después, se encontró con que nadie había intentado hacer un equipo inspirado en el cerebro. «Nadie en ese momento estaba pensando, ‘¿Cómo puedo crear uno?'», dice Mead. «No teníamos ni idea de cómo funcionaba.»

Mead finalmente construyó sus primeros chips neuromórficos, que es como bautizó sus dispositivos inspirados en el cerebro, a mediados de la década de los 80, después de colaborar con neurólogos para estudiar cómo procesan datos las neuronas. Al operar los transistores normales con tensiones inusualmente bajas, podría organizarlos en redes de realimentación que parecían muy diferentes de las colecciones de neuronas pero funcionaban de una manera similar. Él usó ese truco para emular los circuitos de procesamiento de datos en la retina y cóclea, construyendo chips que realizan actos como la detección de los bordes de los objetos y las características de una señal de audio. Pero los chips resultaron difíciles de usar, y el esfuerzo fue limitado por la tecnología de fabricación de chips. Con la informática neuromórfica siendo sólo una curiosidad, Mead trasladó su atención a otros proyectos. «Fue más difícil de lo que pensaba», reflexiona. «El cerebro de una mosca no parece tan complicado, pero hace cosas que hasta hoy no podemos hacer. Eso te dice algo.»

Las neuronas por dentro

El laboratorio Almaden de IBM, cerca de San José, se encuentra cerca pero separado Silicon Valley… tal vez el punto de partida ideal para repensar los fundamentos de la industria de la computación. Llegar allí implica conducir por una calle en forma de magnolia en el borde de la ciudad y subir por tres kilómetros de curvas. El laboratorio se encuentra en medio de 2.317 hectáreas protegidas de colinas. En el interior, los investigadores caminan por largos, tranquilos, anchos pasillos, y reflexionan sobre los problemas. Aquí, Modha lidera el mayor de los dos equipos reclutados por DARPA para romper la dependencia de la industria de la computación del esquema von Neumann. El enfoque básico es similar al de Mead: construir chips de silicio con elementos que funcionen como neuronas. Pero él tiene la ventaja de los avances en la neurociencia y la fabricación de chips. «El tiempo lo es todo; no estaba todo bien para Carver», dice Modha, quien tiene la costumbre de cerrar los ojos para pensar, respirar y reflexionar antes de hablar.

IBM fabrica chips neuromórficos usando las colecciones de 6.000 transistores para emular el comportamiento pulsante eléctrico de una neurona y luego cablea entre sí las neuronas de silicio. La estrategia de Modha para combinarlas para construir un sistema similar al cerebro se inspira en los estudios sobre la corteza cerebral, la arrugada capa exterior del cerebro. Aunque diferentes partes de la corteza tienen diferentes funciones, como el control de idioma o movimiento, están todas compuestos de las llamadas microcolumnas, una repetición de grumos de 100 a 250 neuronas. Modha dio a conocer su versión de una microcolumna en 2011. Una partícula de silicio un poco más grande que una cabeza de alfiler, que contenía 256 neuronas de silicio y un bloque de memoria que define las propiedades de hasta 262.000 conexiones sinápticas entre ellas. Programando esas sinapsis correctamente se puede crear una red que procesa y reacciona a la información tal como lo hacen las neuronas de un cerebro de verdad.

Ajustar ese chip para trabajar en un problema implica programar una simulación del chip en un ordenador convencional y luego transferir la configuración al chip real. En un experimento, el chip podía reconocer los dígitos escritos a mano del 0 al 9, incluso predecir qué número se está empezando a trazar con un lápiz digital. En otra, la red del chip fue programado para jugar una versión del juego de vídeo de Pong. En una tercera, dirigió un pequeño vehículo aéreo no tripulado para seguir la doble línea amarilla en la carretera que se aproxima el laboratorio de IBM. Ninguna de estas hazañas están fuera del alcance de los programas convencionales, pero se logra utilizando una fracción del código, energía y circuitos que normalmente se requieren.

Modha está probando las primeras versiones de un chip más complejo, hecho de una red de núcleos neurosinápticos puestos en un mosaico que forma una especie de rudimentario corteza con un total de más de un millón de neuronas. El verano pasado, IBM también anunció una arquitectura de programación neuromórfica basada en bloques modulares de código llamados corelets. La intención es que los programadores combinen y ajusten corelets de un menú pre-existente, para evitarles la lucha con las sinapsis y las neuronas de silicio. Ya han sido diseñados más de 150 corelets, para tareas que van desde el reconocimiento de la gente en videos a distinguir entre la música de Beethoven y Bach.

Máquinas de aprendizaje

En otra ladera en California, 480 kilómetros al sur, la otra parte del proyecto de DARPA procura hacer chips que imiten el cerebro aún más estrechamente. HRL, que tiene vistas a Malibu desde las estribaciones de las montañas de Santa Mónica, fue fundada por Hughes Aircraft y ahora opera como una empresa conjunta de General Motors y Boeing. Con un estanque koi, palmeras y plantas bananeras, la entrada se parece a un hotel de la época dorada de Hollywood. Además, cuenta con una placa conmemorativa del primer láser funcional construido en el año 1960 en lo que entonces se llamaba Hughes Research Labs.

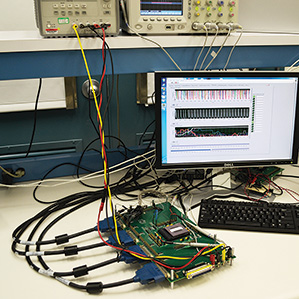

Un microchip desarrollado en HRL aprende como un cerebro biológico

mediante el fortalecimiento o el debilitamiento de conexiones de tipo sináptico

En un banco en un laboratorio sin ventanas, el chip de Narayan Srinivasa se encuentra en el centro de una maraña de cables. La actividad de las 576 neuronas artificiales aparece en una pantalla de computadora como un desfile de picos, un EEG para un cerebro de silicio. El chip HRL tiene neuronas y sinapsis igual que el de IBM. Pero al igual que las neuronas en su cerebro, las que están en el chip de HRL ajustan las conexiones sinápticas cuando se exponen a los nuevos datos. En otras palabras, el chip aprende a través de la experiencia.

Los chips HRL imitan dos fenómenos de aprendizaje en el cerebro. Uno de ellas es que las neuronas se vuelven más o menos sensibles a las señales de otra neurona dependiendo de la frecuencia con que llegan esas señales. El otro es más complejo: un proceso que se cree que apoya el aprendizaje y la memoria, conocido como plasticidad dependiente del tiempo de los picos. Esto hace que las neuronas sean más sensibles a otras neuronas que han tendido a coincidir muy de cerca con su propia actividad de señales en el pasado. Si los grupos de neuronas están trabajando juntas de manera constructiva, las conexiones entre ellas se fortalecen, mientras que las conexiones menos útiles caen en un estado latente.

Los resultados de experimentos con versiones simuladas de los chips son impresionantes. El chip jugó un juego virtual de Pong, al igual que lo hizo el chip de IBM. Pero a diferencia de los chips de IBM, el HRL no estaba programado para jugar el juego: sólo para mover su paleta, sentir la bola y recibir una retroalimentación que recompensaba un tiro acertado y castigaba uno perdido. Un sistema de 120 neuronas comenzó dando golpes, pero dentro de unas cinco jugadas se había convertido en un jugador experto. «Usted no se programa», dice Srinivasa. «Usted sólo se dice ‘bien hecho’, ‘mal hecho’, y se da cuenta de lo que debería haber hecho. «Si se añaden bolas extra, paletas, o adversarios, la red se adapta rápidamente a los cambios.

Este enfoque podría eventualmente permitir que los ingenieros crearan un robot que vaya a los tumbos a través de una especie de «infancia», encontrando la manera de moverse y navegar. «No se puede capturar la riqueza de todas las cosas que suceden en el entorno del mundo real, así que usted debe hacer que el sistema lo maneje directamente», dice Srinivasa. Máquinas idénticas podrían incorporar, entonces, lo que la original ha aprendido. Pero dejanr a los robots cierta capacidad para aprender después de ese punto también puede ser de ayuda. De esa manera se podrían adaptar si están dañados, o ajustar su paso a los diferentes tipos de terreno.

La primera prueba real de esta visión de la computación neuromórficos llegará el próximo verano, cuando el chip HRL esté programado para escapar de su mesa de laboratorio y tomar vuelo en un avión del tamaño de la palma de una mano aleteando sus alas, llamado Snipe. Mientras los humanos pilotean a distancia el avión a través de una serie de habitaciones, el chip tomará los datos de la cámara de la nave y otros sensores. En algún momento, al chip se le dará una señal que significa «Presta atención aquí». La siguiente vez que Snipe las visite esa habitación, el chip encenderá una luz para indicar que recuerda. La ejecución de este tipo de reconocimiento normalmente requeriría demasiada energía eléctrica y de computación para un avión pequeño de este tipo.

Inteligencia extraña

A pesar de los éxitos modestos pero significativos de los chips Synape, todavía no está claro si la ampliación de escala de estos chips producirá máquinas con facultades tipo cerebrales más sofisticadas. Y algunos críticos dudan de que a los ingenieros alguna vez les sea posible copiar la biología de manera suficientemente cercana como para capturar estas habilidades.

IBM utilizó esta simulación de las vías nerviosas de largo alcance en

un mono macaco para guiar el diseño de los chips neuromórficos

El neurocientífico Henry Markram, que descubrió la plasticidad dependiente de los tiempos de los pulsos, ha atacado el trabajo de Modha en las redes de neuronas simuladas diciendo que su comportamiento es demasiado simplista. Él cree que emular con éxito las facultades del cerebro requiere copiar las sinapsis hasta la escala molecular, ya que el comportamiento de las neuronas se ve influenciado por las interacciones de docenas de canales de iones y miles de proteínas, señala, y hay numerosos tipos de sinapsis, todas ellas comportándose de formas no lineales o caóticas. En opinión de Markram, capturar las capacidades de un cerebro real requeriría que los científicos incorporen todas esas características.

Los equipos de DARPA contestan que no tienen que captar la complejidad del cerebro para conseguir que se hagan cosas útiles, y que se puede esperar que las generaciones sucesivas de sus chips se acerquen a representar a la biología. HRL espera mejorar sus chips al permitir que las neuronas de silicio regulen su propio régimen de disparo como lo hacen los cerebros, e IBM está escribiendo el cableado de las conexiones entre los núcleos en su último chip neuromórfico de una manera nueva, utilizando percepciones en las simulaciones de las conexiones entre las diferentes regiones de la corteza de un macaco.

Modha cree que estas conexiones pueden ser importantes para el funcionamiento de nivel superior del cerebro. Sin embargo, incluso después de estas mejoras, estos chips aún estarán lejos de la enmarañada, compleja realidad de los cerebros. Parece poco probable que alguna vez los microchips coincidan en juntar, como los cerebros, 10 mil millones de conexiones sinápticas en un solo centímetro cuadrado, a pesar de que HRL está experimentando con una forma más densa de memoria basada en unos exóticos dispositivos conocidos como memristores.

Al mismo tiempo, los diseños neuromórficos quedan aún lejos de la mayoría de las computadoras que tenemos hoy. Tal vez es mejor reconocer que estos chips son algo completamente aparte, una nueva y extraña forma de inteligencia.

Pueden ser extraño, pero quien encabeza la estrategia de investigación de IBM, Zachary Lemnios, predice que vamos a querer familiarizarse con ellos muy pronto. Muchas grandes empresas ya sienten la necesidad de un nuevo tipo de inteligencia computacional, dice él: «El enfoque tradicional consiste en añadir más capacidad de cálculo y algoritmos más potentes, pero ya no se escala, y lo estamos viendo «. Como ejemplos, cita el asistente personal de Apple Siri, y los coches auto-conducidos de Google. Estas tecnologías no son muy sofisticados en su manera de entender el mundo que les rodea, dice Lemnios, para navegar, los coches de Google se basan en gran medida en datos de mapas precargados, mientras que Siri descansa en servidores en nube distantes para el reconocimiento de voz y procesamiento del lenguaje, causando notables retrasos.

Hoy en día la vanguardia del software de inteligencia artificial es una disciplina conocida como «aprendizaje profundo», adoptada por Google y Facebook, entre otros. Se trata de utilizar el software para simular redes de neuronas muy básicas en la arquitectura normal de la computadora. Pero ese enfoque, que produce el software de reconocimiento de gatos de Google, se basa en grandes agrupaciones de computadores para ejecutar las redes neuronales simuladas y alimentar los datos. Las máquinas neuromórfica deberían permitir que esta facultades se envasen en dispositivos compactos y eficientes para situaciones en las que no es práctico conectarse a un centro de datos distante. IBM ya está hablando con los clientes interesados en utilizar sistemas neuromórficos. Procesamiento de vídeos de seguridad y la predicción de los fraudes financieros están en el frente de la línea, ya que ambos requieren de aprendizaje complejo y el reconocimiento de patrones en tiempo real.

Cuándo y cómo se utilizarán los chips neuromórficos finalmente, lo más probable es que sea en colaboración con las máquinas de von Neumann. Todavía habrá necesidad de manejarse con números, e incluso en sistemas que se enfrenten a problemas tales como el análisis de imágenes, será más fácil y más eficiente tener una computadora convencional al mando. Los chips neuromórficos podrían ser utilizados para ciertas tareas en particular, al igual que un cerebro se basa en las diferentes regiones especializadas para llevar a cabo diferentes trabajos.

Como ha sido generalmente el caso en toda la historia de la informática, es probable que el primero de estos sistemas será desplegado al servicio de los militares de EE.UU. «No es mística o mágica», dice Pratt Gill de la computación neuromórfica, quien gestiona el proyecto Synapse en DARPA. «Es una diferencia de arquitectura que lleva a un equilibrio diferente entre la energía y el rendimiento.» Pratt dice que las UAVs (aeronaves de vuelo autónomo), en particular, podrían utilizar este criterio. Los chips neuromórficos podrían reconocer puntos de referencia o metas sin transferencias de datos voluminosos y potentes computadoras convencionales que se necesitan ahora para procesar las imágenes. «En lugar de enviar video de un grupo de tipos, podría decir: ‘Hay una persona en cada una de estas posiciones; parece que están corriendo'», explica.

Esta visión del nuevo tipo de chip de computadora es la que tanto Mead y von Neumann seguramente reconocerían.

Fuente: Technology Review. Aportado por Eduardo J. Carletti

Más información:

- Superconductores podrían simular el cerebro

- Computación similar al cerebro en una capa molecular orgánica

- ¿Cuándo seremos capaces de construir cerebros como los nuestros?

- Construyendo un cerebro en un chip de silicio

- Avatares immortales: haz una copia de seguridad de tu cerebro… y nunca mueras

- Avanzan levantado un mapa del cerebro de la mosca de la fruta

- Los cartógrafos del cerebro que han interesado a Obama

- Estamos construyendo un modelo del cerebro humano de 1.000 millones de euros

- Un implante para replicar las señales del cerebro en tiempo real

- Memristores: el futuro de las memorias para computadoras