Entre todas las inauguraciones fallidas, hubo una especialmente espectacular. Entre gran pompa y ceremonia —por no hablar de los oscuros rumores sobre que se acercaba el final del mundo— el Gran Colisionador de Hadrones (LHC), el colisionador de partículas más potente del mundo, se conectaba en septiembre del año pasado. Nueve días más tarde un cortocircuito y una catastrófica filtración de helio líquido apagaban ignominiosamente la máquina

Ahora viene la toma dos. Algún día futuro, si todo va según el plan, los rayos de protones empezarán a recorrer el anillo en las profundidades bajo el CERN, el hogar del LHC en las afueras de Ginebra en Suiza.

El Premio Nobel Steven Weinberg está preocupado. No es que piense que el LHC creará un agujero negro que se tragará el planeta, o que el reinicio terminará en una debacle técnica como el año pasado. No, en realidad está preocupado por que el LHC encuentre lo que algunos llaman la “partícula de Dios”, el popular y vergonzosamente grandioso apodo para el aún no detectado bosón de Higgs.

“Estoy aterrado”, dice. “Descubrir el Higgs sería una crisis”.

¿Por qué? Las pruebas para el Higgs serían la última piedra de un edificio que los físicos de partículas han estado construyendo desde hace medio siglo, la fenomenalmente exitosa teoría conocida simplemente como el Modelo Estándar. Describe todas las partículas conocidas, así como tres de las cuatro fuerzas que actúan sobre ellas: el electromagnetismo y las fuerzas nucleares débil y fuerte.

También está manifiestamente incompleta. Sabemos a partir de lo que la teoría no explica que debe ser parte de algo mucho más grande. Por lo cual, si el LHC encuentra el Higgs y nada más que el Higgs, el Modelo Estándar estará arreglado. Pero entonces la física de partículas estará en un callejón sin salida, sin pistas sobre a dónde ir luego.

De ahí los temores de Weinberg. No obstante, si los teóricos están en lo cierto, antes de encontrar el Higgs, el LHC verá el primer esbozo de algo mucho mayor: la gran y predominante teoría conocida como supersimetría, o SUSY, como se la conoce cariñosamente, es una osada teoría que dupica el número de partículas necesarias para explicar el mundo. Y podría ser justo lo que los físicos de partículas necesitan para indicarles el camino a una nueva luz.

Pero, ¿qué hay de malo en el modelo estándar? Primero de todo, hay algunos pecados obvios por omisión. No se dice nada en absoluto de la cuarta fuerza fundamental de la naturaleza, la gravedad, y también guarda silencio sobre la naturaleza de la materia oscura. La materia oscura no es un asunto trivial: si nuestra interpretación de ciertas observaciones astronómicas es correcta, este material supera en peso a la materia convencional del cosmos en más de 4 a 1.

Irónicamente, no obstante, el verdadero problema empieza con el Higgs. El Higgs viene a resolver un problema realmente masivo: el hecho de que los bloques básicos que forman la materia común (cosas tales como electrones y quarks, colectivamente conocidos como fermiones) y las partículas que portan fuerzas (colectivamente conocidos como bosones) tienen todas una propiedad que llamamos masa. Las teorías no podían encontrar un patrón para la masa de las partículas y no podían predecirlas; tenían que medirse en experimentos y ser añadidas a la teoría a mano.

Estos “parámetros libres” eran vergonzosos cabos sueltos en las teorías que se tejían entre sí para finalmente formar lo que se convirtió en el Modelo Estándar. En 1964, Peter Higgs de la Universidad de Edimburgo en el Reino Unido, y François Englert y Robert Brout de la Universidad Libre de Bruselas (ULB) en Bélgica llegaron de manera independiente a una forma de vincularlas.

Este mecanismo se vio como un campo cuántico que impregna todo el cosmos. Llamado luego campo de Higgs, confiere masa a todas las partículas. La masa que adquiere una partícula elemental como un electrón o un quark depende de la fuerza de su interacción con el campo de Higgs, cuyos “cuantos” son bosones de Higgs.

Campos como éste son clave para la comprensión de Modelo Estándar, dado que describen cómo actúan las fuerzas nucleares débil y fuerte y electromagnética sobre las partículas a través del intercambio de varios bosones: las partículas W y Z, gluones y fotones. Pero la teoría de Higgs, aunque elegante, llevaba un aguijón en su cola: ¿cuál es la masa del propio Higgs? Debería consistir en una masa central más la contribución de sus interacciones con otras partículas elementales. Cuando se hace la suma de esas contribuciones, la masa del Higgs aumenta sin control.

Las pistas experimentales ya nos han sugerido que la masa del Higgs debe estar en algún punto entre 114 y 180 gigaelectrón-voltios, lo que es entre 120 y 190 veces la masa de un protón o un neutrón, y fácilmente el tipo de energía que puede alcanzar el LHC. La teoría, sin embargo, llega a valores 17 o 18 órdenes de magnitud mayores, una catastrófica discrepancia conocida como el “problema de la jerarquía”. La única forma de hacer que encaje en el Modelo Estándar es ajustar ciertos parámetros con una precisión de una parte en 1034, algo que los físicos encuentra poco natural y repugnante.

Tres en uno

El problema de la jerarquía no es el único defecto en el Modelo Estándar. Hay otro problema sobre cómo reunir todas las fuerzas. En el universo actual, las tres fuerzas tratadas por el Modelo Estándar tienen muy distintos alcances e intensidades. A nivel subatómico, la fuerza fuerte es la más poderosa, la débil es la más débil y la fuerza electromagnética está entre ambas.

Tres fuerzas en una

Hacia el final de la década de los 60, sin embargo, Weinberg, que estaba entonces en la Universidad de Harvard, demostró junto a Abdus Salam y Sheldon Glashow que esto no había sido siempre así. En el tipo de energías predominantes en el joven universo, las fuerzas débil y electromagnética, tenían la misma intensidad; de hecho, se unificaban. La expectativa era que si se extrapolaba lo suficiente hacia atrás hacia el Big Bang, la fuerza fuerte también sucumbiría, y se unificaría con la electromagnética y la débil en una única súper-fuerza.

En 1974 Weinberg y sus colegas Helen Quinn y Howard Georgi demostraron que el Modelo Estándar podía realmente hacer que sucediera, pero sólo de manera aproximada. Al principio se vio como un gran éxito, pero esta reunificación no tan exacta empezó pronto a crear fallos en los físicos que trabajaban en las “grandes teorías unificadas” de las interacciones de la naturaleza.

Alrededor de esta época es cuando hace su aparición la supersimetría, debutando en el trabajo de los físicos soviéticos Yuri Golfand y Evgeny Likhtman que nunca tuvo repercusión en occidente. Se debió a Julius Wess de la Universidad de Karlsruhe en Alemania y Bruno Zumino, de la Universidad de California en Berkeley, el llevar sus radicales prescripciones a un público más amplio unos años después.

Wess y Zumino estaban tratando de aplicar el principio simplificador favorito de la física, la simetría, al zoo de partículas subatómicas. Su objetivo era demostrar que la división del dominio de partículas en fermiones y bosones es el resultado de una pérdida de simetría que hubo en los inicios del universo.

Zoo de partículas

De acuerdo con la supersimetría, cada fermión está emparejado con un bosón supersimétrico más masivo, y cada bosón con un súper-hermano fermiónico. Por ejemplo, el electrón tiene el selectrón (un bosón) como su compañero supersimétrico, con el fotón emparejado con el fotino (un fermión). En esencia, las partículas que conocemos son, meramente, los renacuajos de una camada el doble de grande.

La clave para la teoría es que en la sopa de alta energía de los inicios del universo, las partículas y sus supercompañeros eran indinstinguibles. Cada par coexistía como entidades individuales sin masa. Conforme el universo se expandía y enfriaba, no obstante, esta supersimetría se rompió. Compañeros y supercompañeros tomaron caminos distintos, convirtiéndose en partículas individuales con masas distintas entre sí.

La supersimetría era una idea llamativa, pero también, al parecer, poco recomendable, aparte de su atractivo para los fetichistas de la simetría. Hasta que, aquí aparece, es aplicable al problema de jerarquía. Resultó que la supersimetría podía solucionar todas esas molestas contribuciones procedentes de las interacciones de Higgs con partículas elementales, las que que provocan que la masa se descontrole. Simplemente se cancelan por las contribuciones de sus compañeros supersimétricos. “La supersimetría hace que la cancelación sea muy natural”, dice Nathan Seiberg, de la Universidad de Princeton.

Eso no era todo. En 1981 Georgi, junto con Savas Dimopoulos de la Universidad de Stanford, rehicieron los cálculos de reunificación de fuerzas que había realizado con Weinberg y Quinn, pero con la supersimetría añadida a la combinación. Encontró que las curvas que representaban la intensidad de las tres fuerzas podía unirse con asombrosa precisión en los inicios del universo. “Si tienes dos curvas, no es sorprendente que se corten en algún punto”, dice Weinberg. “Pero si tienes tres curvan que se cortan en el mismo punto, entonces no es tan trivial”.

Este segundo golpe a favor de la supersimetría fue suficiente para convertir a muchos físicos en verdaderos creyentes. Pero cuando empezaron a estudiar algunas de las cuestiones generadas por la nueva teoría, las cosas se pusieron realmente interesantes.

Una apremiante cuestión concernía al paradero actual de las partículas supersimétricas. Electrones, fotones y todo lo demás están a nuestro alrededor, pero no hay señales de selectrones y fotinos, ni en la naturaleza ni en ningún experimento de acelerador de alta energía hasta el momento. De existir tales partículas, deben ser extremadamente masivas, requiriendo su creación enormes cantidades de energía.

Unas partículas tan grandes no durarían mucho, ya que se desintegrarían en un residuos de partículas supersimétricas más ligeras y estables, conocidos como neutralinos. Aún masivos, los neutralinos no tienen carga eléctrica e interactúan con la materia normal de forma extremadamente tímida por medio de la fuerza nuclear débil. No es sorprendente que hayan escapado a la detección hasta el momento.

Cuando los físicos calcularon cuántos neutralinos residuales debería haber, quedaron desconcertados. Era una cantidad descomunal, mucho más que toda la materia normal del universo.

¿Empieza a sonar familiar? Sí, así es: parecía que los neutralinos cumplían todos los requisitos para ser esa materia oscura que las observaciones astronómicas nos persuaden de que debe dominar el cosmos. Un tercer golpe a favor de la supersimetría.

Cada una de las tres cuestiones que la supersimetría se propone resolver —el problema de jerarquía, el problema de la reunificación y el problema de la materia oscura— podría tener una respuesta única. Pero los físicos siempre se inclinan más a favor de las teorías de propósito general, si pueden encontrar una. “Es verdaderamente tranquilizador que haya una idea que resuelva estas tres cosas independientes en su lógica”, dice Seiberg.

El ámbito de la supersimetría no acaba aquí. Como Seiberg y su colega de Princeton Edward Witten han demostrado, la teoría también puede explicar por qué los quarks nunca se han podido ver en forma aislada, sino siempre en grupos unidos por la fuerza fuerte en partículas mayores como protones y neutrones. En el modelo estándar no existe ninguna indicación matemática de por qué debería ser así; con la supersimetría, eso se desprende de forma natural de las ecuaciones. De forma similar, las matemáticas derivadas de la supersimetría pueden decirnos de cuántas formas se puede plegar una superficie de cuatro dimensiones, un problema de otra forma intratable en topología.

Todo esto parece indicar una verdad fundamental encerrada dentro de la teoría. “Cuando algo tiene aplicaciones más allá de aquello para lo que ha sido diseñado, entonces dices, ‘bueno, esto va más al fondo’”, dice Seiberg. “La belleza de la supersimetría en realmente abrumadora”.

Por desgracia, la belleza matemática ni las promesas alcanzan por sí mismas. También se necesitan pruebas experimentales. “Es vergonzoso”, dice Michael Dine de la Universidad de California en Santa Cruz. “Hay un montón de papel gastado en algo que se sostiene con hilos”.

Se podrían encontrar pruebas circunstanciales de supersimetría en distintos experimentos diseñados para encontrar y caracterizar la materia oscura en los rayos cósmicos que pasan a través de la Tierra. Estos incluyen al experimento de Búsqueda Criogénica de Materia Oscura (Cryogenic Dark Matter Search, CDMS) dentro de la Mina Soudan en el norte de Minnesota y el experimento Xenon bajo la montaña Gran Sasso en Italia central. Sondas espaciales como el satélite Fermi de la NASA también escrutan la Vía Láctea buscando las señales que se tiene la esperanza que se produzcan cuando dos neutralinos se encuentran y aniquilan.

La mejor prueba vendría, sin embargo, si pudiésemos producir neutralinos directamente por medio de colisiones en un acelerador. El problema es que no estamos por completo seguros de cuán potente debería ser ese acelerador. La masa de los supercompañeros depende con precisión de cuándo se rompió la supersimetría al enfriarse el universo y las partículas estándar se separaron de sus supercompañeras. Distintas versiones de la teoría no han logrado un tiempo consistente para este suceso. Algunas variantes sugieren, incluso, que ciertos supercompañeros son lo bastante ligeros para haber sido generados en aceleradores como el Gran Colisionador de Electrón-Positrón —el predecesor del LHC en el CERN— o el colisionador Tevatron en Batavia, Illinois. Pero ninguno de los aceleradores ha encontrado nada.

La razón de que los físicos estén tan entusiasmados con el LHC es que el tipo de supersimetría que mejor resuelve el problema jerárquico se hará visible a las mayores energías que explorará el LHC. De forma similar, si los neutralinos tienen la masa adecuada para formar la materia oscura, deberían producirse en gran cantidad en el LHC.

Desde el accidente durante la puesta en marcha del acelerador el año pasado, el CERN ha adoptado una actitud más tranquila para el reinicio del LHC. Durante el primer año hará impactar dos rayos de protones con una energía total de 7 teraelectrón-voltios (TeV), la mitad de la energía para la que fue diseñado. Aun así es un paso adelante importante respecto a los 1,96 TeV que podía lograr el Tevatron, el anterior poseedor del récord. “Si las partículas supersimétricas más pesadas pesan menos de un teraelectrón-voltio, entonces podrían reultar generadas bastante copiosamente en las primeras etapas de ejecución del LHC”, dice el teórico del CERN John Ellis.

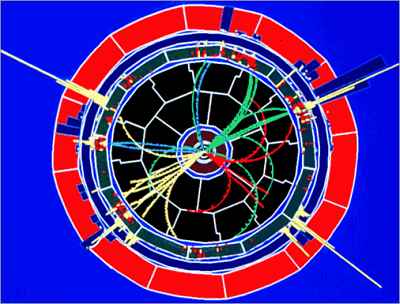

De ser así, los sucesos después de que se reinicie el acelerador podrían ser paradójicos. Los protones que impacten en el LHC estarán compuestos de partículas hechas de quarks y gluones, y producirán unos restos extremadamente confusos. Podría llevar mucho tiempo encontrar al Higgs entre toda esa basura, dice Ellis.

Cualquier partícula supersimétrica, por otra parte, se desintegrará en apenas 10-16 segundos en un montón de partículas secundarias, culminando en una cascada de neutralinos. Debido a que los neutralinos apenas interaccionan con otras partículas, escaparán a los detectores del LHC. Paradójicamente, esto puede hacerlos fáciles de detectar, dado que la energía y momento que portan parecerá que se desvanece. “Esto, en principio, es algo bastante distintivo”, dice Ellis.

Por lo que, si existen pruebas de la supersimetría en la forma que esperan la mayor parte de teóricos, podrían ser descubiertas mucho antes de la partícula de Higgs, cuyos problemas propone resolver SUSY. Cualquier visión de algo que parezca un neutralino serían muy buenas noticias. Al mneos sería el mejor avistamiento, hasta la fecha, de una partícula de materia oscura. Mejor aún, nos diría que la naturaleza es fundamentalmente supersimétrica.

Hay una sensación de entusiasmo palpable en lo que podría encontrar el LHC en los próximos años. “Estaré encantado si es la supersimetría”, dice Seiberg. “Pero también si es alguna otra cosa. Necesitamos más pistas sobre la naturaleza. El LHC nos dará estas pistas”.

Fuente: New Scientist, traducción de Ciencia Kanija, adaptaciones por Eduardo J. Carletti

Más información: