Hao Li recuerda haber visto Jurassic Park cuando era niño: «Ese momento de ver algo que no existe en la realidad, pero que se veía tan real, fue sin duda lo que me hizo pensar en hacer esto», dice

Li me cuenta su historia una tarde, mientras cenamos en la cafetería de la Industrial Light & Magic, el famoso estudio de San Francisco de efectos visuales donde él ha estado trabajando en una manera de capturar digitalmente las expresiones faciales de los actores de las próximas películas de Star Wars.

Cuando se estrenó Jurassic Park, Li tenía 12 años y vivía en lo que él llama la ciudad «boonie» de Saarbrücken, Alemania, donde sus padres se habían trasladado desde Taiwán para que su padre completara un doctorado en química. Ahora, 20 años después, si todo va según lo previsto, la innovación de Li va a alterar radicalmente la forma en que se hacen las películas llenas de efectos, difuminando la línea entre los actores humanos y lo digital.

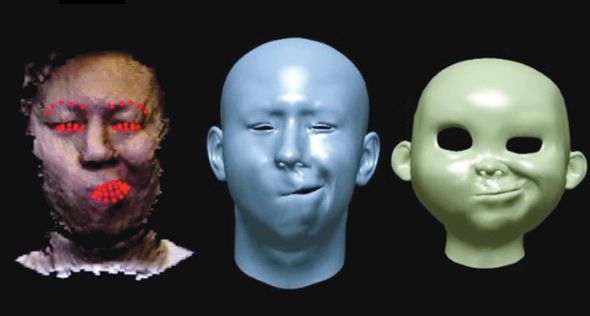

Los artistas de efectos visuales suelen capturar as actuaciones humanas por medio de pequeñas bolas o etiquetas que se colocan en la cara y el cuerpo de un actor para seguir el movimiento. Los datos de captura del movimiento de esos marcadores se convierte a continuación en un archivo digital que puede ser manipulado.

Pero los marcadores son una distracción y son molestos para los actores, y no son muy buenos para capturar los cambios sutiles en la expresión facial.

El desarrollo de Li implica sensores de profundidad, la misma tecnología que se utiliza en los sistema de movimiento de los juegos, como el Kinect en la Xbox. Cuando se dirige una cámara con sensores de profundidad a la cara de un actor, el software de Li analiza los datos digitales con el fin de averiguar cómo se modifican las formas faciales entre un fotograma y el siguiente. Cuando los labios del actor se curvan en una sonrisa, el algoritmo mantiene un registro de las líneas y las sombras de expansión y contracción, en esencia «identificando» los labios del actor. A continuación, el software aplica el rostro del actor a una versión digital.

El trabajo de Li mejora la autenticidad de las performances digitales, al mismo tiempo que acelera la producción.

Li es temerario aunque amigable, no siente vergüenza de proclamar sus logros, sus ambiciones, y las posibilidades de su software. Su algoritmo ya se utiliza en algunos escáneres médicos, donde se realiza un seguimiento de la ubicación exacta de un tumor mientras el paciente respira. En otro proyecto, se ha utilizado el software para crear un modelo digital de un corazón latiendo.

Si uno le pregunta si se puede utilizar la tecnología para leer las emociones humanas, o si él va a encontrar alguna otra remota posibilidad, es probable que diga: «Estoy trabajando en eso, también.»

Cuando le pregunto si habla alemán, Li sonríe y dice que sí, «francés, alemán, chino e inglés.» Este otoño, comenzará a trabajar en Los Angeles como profesor asistente en un laboratorio de gráficos por ordenador de la Universidad del Sur de California. Pero las películas de Hollywood no son el final en este juego. «Los efectos visuales son una bonita caja de arena para pruebas de diseño, pero no es el objetivo final», dice Li. Más bien, él ve a sus esfuerzos en la captura de datos y la simulación en tiempo real como un paso adelante en el camino a enseñarle a las computadoras a reconocer mejor lo que está pasando a su alrededor.

Fuente: Technology Review. Aportado por Eduardo J. Carletti

Más información:

- Investigadores japoneses crean unas gafas para evitar los sistemas de reconocimiento facial

- El sistema de reconocimiento facial de HP ¿es racista?

- La realidad aumentada empieza a hacerse finalmente realidad

- Desarrollan sistema inspirado en la biología para dar movimiento más humano a los ojos robóticos