El temor común es que las máquinas inteligentes se volverán contra los seres humanos. Pero, ¿quién va a salvar a los robots de los demás robots… y de nosotros?, se pregunta Hutan Ashrafian

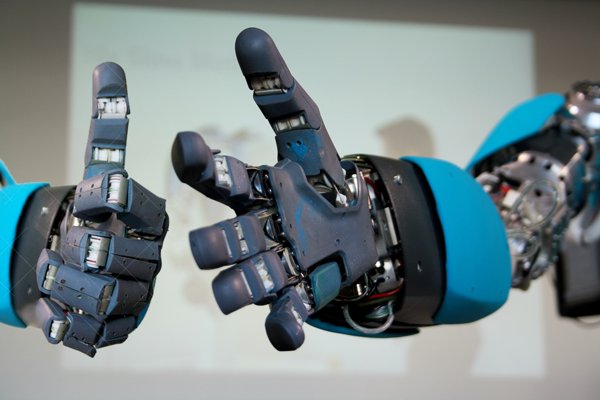

Hay una fuerte posibilidad de que en un futuro no muy lejano, las inteligencias artificiales (IA), tal vez en forma de robots humanoides, se convertirán en entidades capaces de pensamiento consciente. Cualquiera que sea la forma que adopte, es probable que este surgir de la conciencia artificial tenga un impacto sustancial en la sociedad humana.

El co-fundador de Microsoft, Bill Gates, y el físico Stephen Hawking, han advertido en los últimos meses sobre los peligros de que los robots inteligentes se conviertan en demasiado poderosos para que los humanos los puedan controlar. El dilema ético de las máquinas inteligentes, y cómo se relacionan con los seres humanos, ha sido durante mucho tiempo un tema de la ciencia ficción, y ha sido retratado vívidamente en películas como Blade Runner de 1982 y este año Ex Machina.

Los análisis académicos y de ficción de las IA tienden a centrarse en las interacciones humano-robot, haciendo preguntas como: ¿Harían los robots nuestra vida más fácil? ¿Serían peligrosos? ¿Y podrían ser alguna vez una amenaza para la humanidad?

Estas preguntas dejan de lado un punto crucial. Debemos tener en cuenta las interacciones entre los propios robots inteligentes y el efecto que estos intercambios pueden tener sobre sus creadores humanos. Por ejemplo, si tuviéramos que permitir que las máquinas inteligentes cometan injusticias sobre los otros —incluso si estos «crímenes» no tienen un impacto directo en el bienestar humano— esto podría tener consecuencias negativas para nuestra propia humanidad. Estas deliberaciones filosóficas han allanado el camino hacia el concepto de «derechos de las máquinas».

La mayoría de las discusiones sobre el desarrollo de los robots se basan en las Tres Leyes de la Robótica ideadas por el escritor de ciencia ficción Isaac Asimov: los robots no pueden lesionar los seres humanos (o permitir por inacción que sufran daño); los robots deben obedecer las órdenes humanas; y los robots deben proteger su propia existencia. Pero estas reglas no dicen nada sobre cómo los robots deben tratar a los otros robots. No sería razonable para un robot defender los derechos humanos y sin embargo ignorar los derechos de otra máquina pensante sensible.

Los animales que exhiben comportamientos de pensamiento ya gozan de derechos y de protección, y la sociedad civilizada muestra desprecio por las peleas de animales que se establecen para entretenimiento humano. De ello se desprende que no se deben hacer máquinas inteligentes que sean potencialmente mucho más inteligentes que los animales para que luchen para entretenimiento.

Por supuesto, ya se están desarrollando [y utilizando] robots en los conflictos militares. Pero fuera de la guerra, obligar a las IA y los robots al conflicto, o maltratarlos, sería perjudicial para la moral, el bienestar psicológico y ético de la humanidad.

Los robots inteligentes siguen siendo ciencia ficción, pero no es demasiado pronto para tomar en serio estas cuestiones. En el Reino Unido, por ejemplo, el Consejo de Investigación de Ingeniería y Ciencias Físicas y el Consejo de Investigación de las Artes y Humanidades ya han introducido una serie de principios para los diseñadores de robots. Estos refuerzan la posición de que los robots son productos manufacturados, por lo que «los seres humanos, no los robots, son los agentes responsables».

Los científicos, filósofos, los financiadores y los responsables políticos deberían ir un paso más allá y considerar las interacciones robot-robot y IA-IA (IA en IA). Juntos, deberán elaborar una propuesta de una carta internacional para las IA, equivalente a la de la Declaración Universal de los Derechos Humanos de las Naciones Unidas. Esto podría ayudar a orientar una investigación y desarrollo con consideraciones morales en robótica e ingeniería de IA.

Las políticas tecnológicas nacionales del Reino Unido e internacionales deben introducir conceptos IA en IA en los programas actuales destinados a desarrollar IA seguras. Hay que comprometerse con las actividades educativas y de investigación, y continuar creando conciencia filosófica. Incluso podría haber un premio anual IA en IA para la ‘IA diseñada más altruista’.

Los científicos sociales y los filósofos deben ser vinculados a la robótica de vanguardia y la investigación informática. Los financiadores tecnológicos podrían apoyar la reflexión ética sobre los conceptos IA en IA además de financiar el desarrollo de la IA. Los financiadores médicos, como el Wellcome Trust, siguen este modelo ya, apoyando la investigación sobre los cuidados sanitarios de vanguardia y la ética médica y la historia.

Las comunidades actuales y futuras de investigación de Inteligencia Artificial y robótica requieren una exposición continuada a las ideas de IA en IA. Las conferencias centradas en los temas AI en AI podrían tener un eje de investigación, directrices y declaraciones de política. La próxima generación de ingenieros robóticos e investigadores de IA también puede ser llevado a adoptar principios AI en AI a través de cursos híbridos de grado. Por ejemplo, muchas personas que aspiran a entrar en política en el Reino Unido reciben un curso en PPE (politics, philosophy and economics = política, filosofía y economía), podría instaurarse un curso equivalente para los estudiantes con ambiciones en robótica e IA que podría ser CEP (computer science, engineering and philosophy = ciencias de la computación, ingeniería y filosofía).

Debemos extender las Tres Leyes de la Robótica de Asimov para respaldar el trabajo en la interacción AI en AI. Sugiero una nueva ley: todos los robots dotados de razón y conciencia comparable con la humana deben comportarse fraternalmente entre sí, en un espíritu de hermandad.

No hay que subestimar la probabilidad de que existan máquinas pensantes artificiales. La humanidad está llegando al horizonte del nacimiento de una nueva raza inteligente. Aunque esta inteligencia sea o no «artificial», esto no elimina el problema de que la nueva población digital merecerá dignidad y derechos morales, y una nueva ley que los proteja.

Nature 519, 391 ( 26 de marzo 2015 ) doi: 10.1038 / 519391a

Fuente: Nature. Aportado por Eduardo J. Carletti

Más información:

- La inteligencia artificial finalmente se está haciendo inteligente

- Estamos construyendo un modelo del cerebro humano de 1.000 millones de euros

- Ingenieros resuelven un misterio biológico y mejoran la inteligencia artificial

- Kevin Warwick: Con nuestro robot con cerebro de rata estamos intentado averiguar cómo aprendemos y recordamos

- Google y la NASA lanzan el Laboratorio de Inteligencia Artificial Cuántica

- Una IA robótica tan inteligente como para pasar las pruebas de la universidad en Japón

- Por primera vez en la historia una computadora pasa el test de Turing

- Máquinas inteligentes: ¿Qué es lo peor que puede suceder?