Boston Dynamics es exasperantemente atrayente. Debe ser la única empresa de robótica que existe que envía un vídeo a YouTube de un cuadrúpedo autónomo increíblemente ágil llamado «Spot» con una descripción de cuatro frases sin que exista información en su sitio, ningún comunicado de prensa, ninguna entrevista. Porque saben que, de todos modos, todo el mundo lo va a ver y pensará que es impresionante

Spot es un robot de cuatro patas diseñado para uso en interiores y al aire libre. Es alimentado eléctricamente y accionado hidráulicamente. Sopt tiene una cabeza sensora que lo ayuda a navegar y franquear terrenos difíciles. Spot pesa alrededor de 72 kg.

Hemos contactado nuestros conocidos en Boston Dynamics para más detalles, pero hasta que no recibamos respuesta de ellos (y ahora que pertenecen a Google , probablemente vamos a saber de ellos como nunca), vamos a ver qué podemos averiguar del vídeo. Una vez más, nada de lo que sigue viene de Boston Dynamics: sólo hablamos de lo que parece ser nuevo aquí.

En lugar de un enjambre de abejas furiosas, Spot suena como un mal día en el dentista. Todavía es hidráulico, pero está usando una batería para alimentar la bomba hidráulica en lugar de un motor de combustible líquido. Nos sorprende que esto no haya tenido un impacto significativo en el rango, la resistencia y/o el rendimiento (especialmente la capacidad de carga útil) de Spot en relación con algunos de los otros robots de la empresa. Sin embargo, se las arreglaron para hacer que la actualización más reciente de Atlas (su robot humanoide) funcione con baterías que también alimentan una bomba hidráulica, es posible que Spot esté aprovechando la misma tecnología.

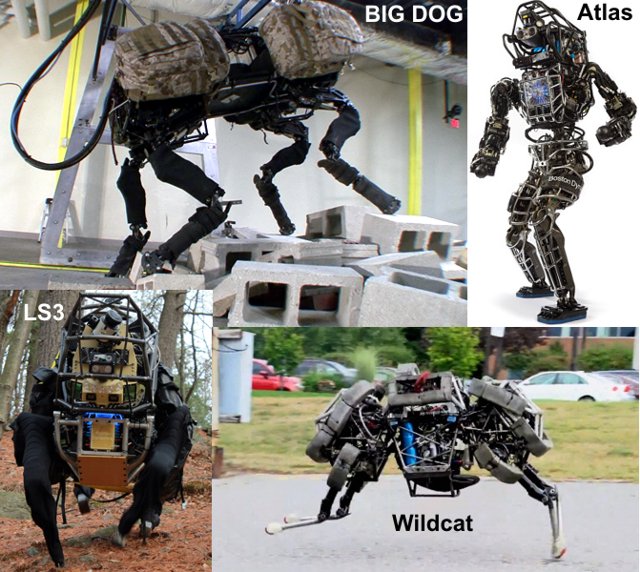

Spot no se ve necesariamente construido específicamente para la velocidad, o con capacidad de carga útil, lo que indica que no es la próxima generación de LS3 o Wildcat. Hemos escuchado que las patas de estos robots pueden ser colocados con sus rodillas enfrentando ya sea hacia atrás o hacia adelante, pero (tal vez) cabe señalar que Wildcat tiene rodillas mirando hacia delante (Cheetah también), y LS3 tiene una combinación de las dos posiciones. Si tuviésemos que adivinar en base a nada en absoluto, podría especular que la configuración de las patas de LS3 es para la carga útil, y la configuración de las patas de Wildcat son para la velocidad. Así que tal vez las piernas de Spot estén diseñados para la agilidad. O tal vez no importa en absoluto. Sinceramente, no lo sabemos.

Spot ciertamente es ágil: parece no tener ningún problema con colinas, o incluso con las escaleras. En cierto modo parece que Spot tal vez no sabe, en realidad, cómo subir escaleras. Tendemos a pensar que no le importa que haya unas escaleras, sólo ve una pendiente empinada y llena de baches, y luego sube las escaleras como si fuera cualquier otro terreno. Usted sabe, ellos se llaman a sí mismos Boston Dynamics por alguna razón.

En cuanto a los sensores, el Velodyne bebé es ciertamente obvio. También, escondidos donde estaría la cabeza de Spot (si tuviera una cabeza), parece estar la misma clase de sensores de visión que tiene Atlas, pero es un poco difícil de ver. El Velodyne no está montado de manera que pueda ver lo que está justo delante del robot, así que para un funcionamiento autónomo tendrá que confiar en algo más para la detección desde cerca.

La adaptabilidad del robot es una gran ventaja aquí, sin embargo: ya que es tan dinámicamente estable, no es necesario calcular la ubicación exacta del pie que adelanta, simplemente lo hace.

La gran pregunta que tenemos ahora (además de todas los otras grandes preguntas sobre cómo funciona esta máquina y lo que puede hacer) es ¿por qué existe este robot? También, ¿para qué se construyó? Antes, cuando Boston Dynamics trabajaba principalmente para los militares, era más fácil discutir sobre posibles aplicaciones, pero ahora que la empresa es parte de Google, tal vez la razón es simplemente «porque podemos, y es genial».

O tal vez se trata de un robot de reparto urbano. Lo escucharon aquí primero, amigos.

En cualquier caso, estamos muy contentos de ver que Boston Dynamics sigue trabajando en impresionantes robots y que no ha desaparecido por completo en la inmensidad de Google.

Fuente: Spectrum IEEE. Aportado por Eduardo J. Carletti

Más información:

- DARPA elige un humanoide de Boston Dynamics para el Desafío de Robótica

- Boston Dynamics, creadora del robot Big Dog, desarrollará un felino robótico que correrá a gran velocidad

- El nuevo vídeo del robot cuadrúpedo BigDog es alucinante y espeluznante

- El robot Asimo cumplió 10 años

- Las tres leyes: robots que prueban a ver si nos hacen daño y aprenden a evitarlo

- Google tiene a prueba un auto inteligente que circula sin conductor

- El robot perro puede moverse sin problema, pero no tiene cabeza

- El BigDog, una mula robótica para llevar el equipaje de las tropas